Hướng dẫn tạo file Robots.txt chuẩn SEO cho Blogspot [MỚI]

Robots.txt là gì?

Robots.txt là một tệp bao gồm các lệnh điều hướng quá trình thu thập dữ liệu của các công cụ tìm kiếm. File này sẽ giúp bạn quản lí được trang nào được phép thu thập dữ liệu và lập chỉ mục (index) lên công cụ tìm kiếm. Điều này rất tốt cho SEO khi bạn ngăn chặn được một số liên kết không mong muốn index lên công cụ tìm kiếm nhưng cũng sẽ phản tác dụng nếu cấu hình file này sai. Trong bài viết này, Giahuyblog sẽ hướng dẫn các bạn cách cấu hình file robots.txt cho Blogspot chuẩn cho SEO.

|

| Robots.txt |

Vì sao nên sử dụng tệp robots.txt?

Chúng ta không bắt buộc phải dùng tệp Robots.txt nhưng sẽ có một số lí do thuyết phục bạn cài đặt file này cho Blogspot của mình.

- Chặn index các tài nguyên không cần thiết (ví dụ: video, file PDF,...)

- Chặn index trang không cần thiết.

- Tối ưu quá trình crawl: Google luôn có một mức thu thập dữ liệu tối đa cho một website trong một khoảng thời gian nhất định. Vì thế, chúng ta cần index trang cần thiết và loại bỏ các trang cần thiết để tiết kiệm cho quá trình crawl này.

Các lệnh cơ bản của file robots.txt

Dưới đây là một số lệnh cơ bản giúp file Robots.txt hoạt động.

- User-agent: là tên của các bot thu thập dữ liệu của các công cụ tìm kiếm.

- Allow: cú pháp cho phép các robot của công cụ tìm kiếm thu thập dữ liệu.

- Disallow: cú pháp không cho phép các robot của công cụ tìm kiếm thu thập dữ liệu.

- Sitemap: khai báo vị trí sitemap của website.

- Crawl-delay: quy định thời gian các crawler phải chờ để thu thập dữ liệu (cú pháp này ít được sử dụng).

Thêm file robots.txt cho blog

Bước 1: Vào trang quản lí blog của bạn > Cài đặt.

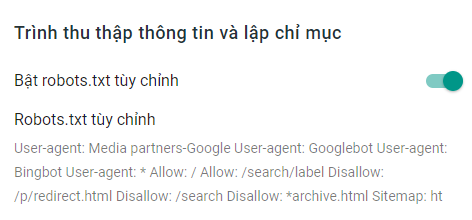

Cấu hình robots.txt chuẩn nhất cho Blogspot

Dưới đây là cấu hình file Robots.txt tốt cho Blogspot.

User-agent: Media partners-Google

User-agent: Googlebot

User-agent: Bingbot

User-agent: *

Allow: /

Allow: /search/label

Disallow: /search

Disallow: *archive.html

Sitemap: https://www.giahuyblog.com/atom.xml?redirect=false&start-index=1&max-results=500Thay giahuyblog.com thành địa chỉ website của bạn và nếu blog bạn có trên 500 bài viết thì hãy thay cuối link sitemap thành con số cao hơn nha!.

Mình sẽ giải thích thêm về cấu hình này:

User-agent: Media partners-Google

User-agent: Googlebot

User-agent: Bingbot

User-agent: *Các dùng trên tức là cho phép các bot vào thu thập dữ liệu như bot của Google, Bing (công cụ này cũng khá phổ biến nên cũng cần thiết) và xác định các công cụ tìm kiếm mà quy tắc được áp dụng trong tệp.

Allow: /

Allow: /search/labelDòng này nghĩa là cho phép index các tiền tố url, ví dụ ở đây mình cho phép index nhãn và các trang khác.

Disallow: /search

Disallow: *archive.htmlỞ đây mình sẽ chặn index các trang tìm kiếm để tránh người dùng click vào mà không có nội dung và cả trang lưu trữ.

Sitemap: https://www.giahuyblog.com/atom.xml?redirect=false&start-index=1&max-results=500Đây là sơ đồ trang web.

Hướng dẫn tùy chỉnh file robots.txt

Nếu bạn muốn chặn index một trang nào đó từ hãy thêm cú pháp:

Disallow: "địa chỉ trang muốn chặn"Ví dụ mình muốn chặn trang sau: https://www.giahuyblog.com/p/redirect.html thì mình sẽ thêm vào file robots.txt.

Disallow: https://www.giahuyblog.com/p/redirect.htmlKiểm tra hoạt động của robots.txt

Sau khi đã chỉnh sửa robots.txt theo ý muốn rồi thì bạn hãy vào trình kiểm tra của google để test xem mình đã chỉnh đúng hay chưa (có thể bỏ qua bước này cũng được).

Kết thúc bài viết

Vậy là bạn đã tạo được file robots.txt để tối ưu SEO cho Blogspot rồi, nếu có thắc mắc gì hãy để lại bình luận dưới bài viết nhé. Cảm ơn bạn đã ghé thăm website.

Nhận xét

Đăng nhận xét